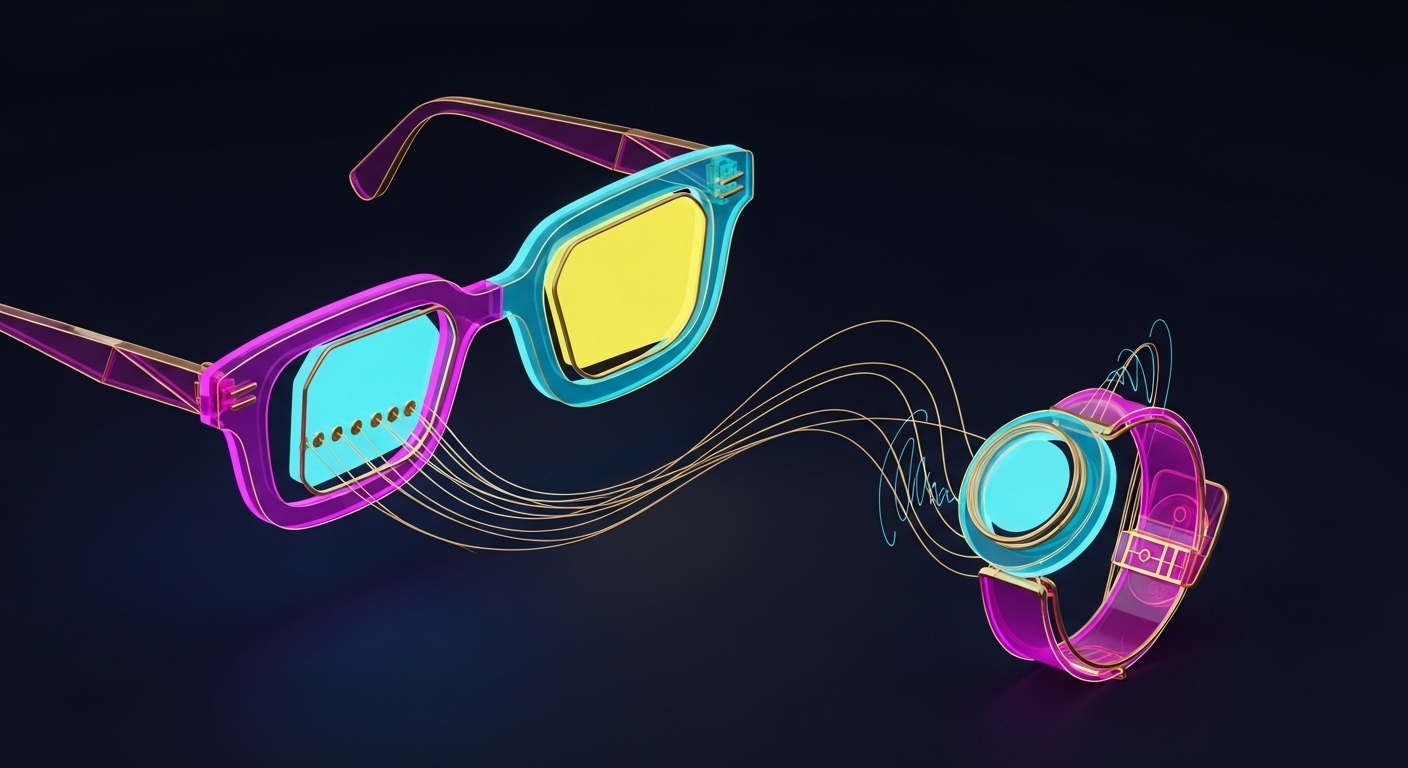

Per la prima volta, i Ray-Ban smart di Meta integrano un display ad alta risoluzione e un sistema di controllo basato su una fascia neurale da polso, riaprendo le discussioni sull’interazione tra uomo e macchina.

[In pillole] La sintesi per chi va di fretta:

Durante Connect, Meta ha presentato i Ray-Ban Display: occhiali smart con schermo integrato e controllo neurale dal polso. Una fascia rileva le intenzioni di movimento per un'interazione discreta. Questo segna un passo verso il metaverso, sollevando dibattiti su privacy e accettazione sociale di tali tecnologie. Disponibili a fine 2025.

Gli occhiali di Meta ora hanno uno schermo, e si controllano con il polso

Durante la sua conferenza annuale Connect, Meta ha presentato la nuova generazione dei suoi occhiali smart realizzati in collaborazione con Ray-Ban. Per la prima volta integrano un display ad alta risoluzione e un sistema di controllo basato su una fascia neurale da polso, un passo ambizioso che riapre molte discussioni sul futuro dell’interazione tra uomo e macchina e sul ruolo che le grandi aziende tecnologiche vogliono avere nella nostra percezione della realtà.

Da anni l’idea di avere informazioni digitali sovrapposte al nostro campo visivo è una delle promesse più ricorrenti e finora deludenti del settore tecnologico.

Tentativi passati, anche da parte di aziende enormi come Google, si sono scontrati con ostacoli tecnologici, problemi di accettazione sociale e una fondamentale domanda: a cosa servono, davvero?

Meta, l’azienda guidata da Mark Zuckerberg che ha investito decine di miliardi di dollari nella visione del metaverso, crede di avere una nuova risposta. Durante l’evento Connect 2025, ha svelato i Meta Ray-Ban Display, un prodotto che pur mantenendo l’aspetto quasi indistinguibile di un normale paio di occhiali da sole, nasconde al suo interno una tecnologia che fino a poco tempo fa apparteneva alla fantascienza.

Il cuore di questa nuova proposta non è solo la capacità di mostrare immagini, ma il modo in cui l’utente interagisce con esse. Il dispositivo rappresenta un’evoluzione significativa rispetto ai modelli precedenti, che si limitavano a integrare fotocamera e altoparlanti.

Ora, in una delle lenti è stato inserito un micro-display ad alta risoluzione, capace di proiettare notifiche, indicazioni stradali, traduzioni in tempo reale e altro ancora, direttamente davanti all’occhio di chi li indossa. La luminosità, che secondo l’azienda può raggiungere i 5.000 nits, dovrebbe garantirne la visibilità anche in piena luce solare, superando uno dei limiti storici di dispositivi simili.

Ma la vera novità, quella che distingue questo dispositivo da quasi ogni altro tentativo precedente, non è tanto nello schermo, quanto nel modo in cui lo si comanda.

Un’interfaccia neurale al polso

Per superare la goffaggine sociale di parlare da soli ai propri occhiali o di toccarne continuamente la stanghetta, Meta ha introdotto un accessorio complementare ma fondamentale: la Meta neural band.

Si tratta di un braccialetto che, indossato al polso, utilizza sensori elettromiografici (EMG) per rilevare i segnali elettrici inviati dal cervello ai muscoli della mano e delle dita.

In pratica, “legge” l’intenzione di movimento, anche quando questo è quasi impercettibile.

Durante la presentazione, come mostrato nella dimostrazione ufficiale di Meta, Zuckerberg ha illustrato come sia possibile scrivere un messaggio semplicemente mimando la digitazione con le dita appoggiate su una gamba, o controllare un’interfaccia virtuale con piccoli gesti della mano che risulterebbero quasi invisibili a un osservatore esterno.

Questa ricerca di un’interazione più discreta e naturale non è un semplice dettaglio tecnico, ma la sfida centrale della moderna progettazione di interfacce e user experience (UI/UX). Il successo di un dispositivo indossabile non dipende solo da cosa fa, ma da come fa sentire l’utente mentre lo usa, eliminando ogni attrito fisico e sociale.

– Leggi anche: L’intelligenza artificiale e l’omnicanalità: come la AI sta ridefinendo l’esperienza cliente nel 2025

L’obiettivo è chiaro: rendere l’uso della tecnologia indossabile un’esperienza fluida, privata, che non crei barriere tra chi la usa e le persone che ha di fronte.

Si tratta di un approccio radicalmente diverso dai comandi vocali, spesso inadatti in luoghi pubblici o affollati, e dai controller fisici, che richiedono di avere le mani impegnate.

Resta da vedere, ovviamente, quanto questo sistema sarà preciso e affidabile nell’uso quotidiano e quale sarà la curva di apprendimento per gli utenti.

Avere un modo così discreto per dare comandi è solo una parte dell’equazione.

L’altra, naturalmente, è ciò che questi comandi permettono di fare e di vedere.

Cosa si vede e a cosa serve

Al di là dell’innovativo sistema di controllo, il valore dei nuovi occhiali si misurerà sulla loro effettiva utilità. Meta ha presentato alcune applicazioni pratiche che vanno oltre la semplice visualizzazione di notifiche.

Una delle più interessanti è la traduzione in tempo reale: durante una conversazione con una persona che parla un’altra lingua, gli occhiali possono mostrare la traduzione di ciò che viene detto sotto forma di sottotitoli.

Un’altra applicazione con un potenziale impatto notevole è quella pensata per le persone con disabilità uditive, che potrebbero vedere la trascrizione di dialoghi e suoni ambientali direttamente nel loro campo visivo, migliorando la loro percezione del contesto circostante.

Queste funzioni, per quanto affascinanti, sono solo l’inizio. Il vero valore del dispositivo, così come è stato per lo smartphone, non risiederà nell’hardware in sé, ma nell’ecosistema di software che nascerà attorno ad esso. La capacità di tradurre o assistere sono esempi di ciò che un mirato sviluppo di app può realizzare quando ha accesso a una piattaforma così personale e contestuale.

A gestire queste funzioni c’è un’intelligenza artificiale integrata, che Meta descrive come “agentica”, ovvero capace non solo di rispondere a comandi diretti ma anche di comprendere il contesto di una conversazione e suggerire proattivamente informazioni o azioni pertinenti.

L’idea è quella di un assistente personale che ascolta e osserva il mondo insieme all’utente, pronto a intervenire quando necessario.

Questo, però, solleva inevitabilmente questioni complesse sulla privacy. Un dispositivo che, per funzionare al meglio, deve costantemente analizzare ciò che vediamo e sentiamo, rappresenta una raccolta di dati personali di una portata senza precedenti.

Meta assicura che i dati saranno processati in modo sicuro, ma il modello di business dell’azienda, storicamente basato sulla profilazione degli utenti, rende legittimo porsi delle domande su come queste informazioni verranno utilizzate in futuro.

Questa complessa tecnologia, inoltre, deve fare i conti con un mercato che in passato si è dimostrato piuttosto scettico verso gli occhiali “intelligenti” e con le ambizioni di un’azienda che non ha mai nascosto il suo obiettivo finale.

Un passo verso il metaverso

Il lancio dei Meta Ray-Ban Display non può essere visto come un evento isolato, ma come un tassello fondamentale nella strategia a lungo termine di Meta per costruire il metaverso. L’obiettivo ultimo è creare un’informatica “contestuale e onnipresente”, in cui il confine tra mondo fisico e digitale si assottiglia fino quasi a scomparire.

Questi occhiali, pur non essendo ancora un dispositivo di realtà aumentata completa (quella che sovrappone oggetti virtuali complessi al mondo reale), servono a uno scopo preciso: normalizzare l’idea di indossare un computer sul viso.

La collaborazione con Ray-Ban è strategica in questo senso: maschera la tecnologia dietro un marchio di moda iconico, rendendo il prodotto desiderabile e socialmente accettabile, a differenza del fallimentare esperimento dei Google Glass di un decennio fa.

Il prezzo, fissato a 799 dollari, posiziona il dispositivo nella fascia alta del mercato dell’elettronica di consumo, limitandone inizialmente la diffusione a un pubblico di appassionati e early adopters. È un costo considerevole per un prodotto la cui utilità quotidiana è ancora tutta da dimostrare su larga scala.

Il vero banco di prova sarà capire se le funzionalità offerte saranno abbastanza convincenti da giustificare non solo la spesa, ma anche l’adozione di un nuovo modo di interagire con la tecnologia che porta con sé implicazioni profonde.

La promessa è quella di un accesso più immediato e integrato alle informazioni, ma la domanda che rimane sospesa è a quale costo.

Stiamo assistendo all’alba di un’era di maggiore efficienza e connessione, o stiamo semplicemente invitando le logiche degli algoritmi e della raccolta dati in uno spazio ancora più intimo della nostra vita: la nostra stessa percezione del mondo?

Con la disponibilità fissata per la fine del 2025, la risposta inizierà a delinearsi presto.